MT5手机下载正版官网:探索自适应算法

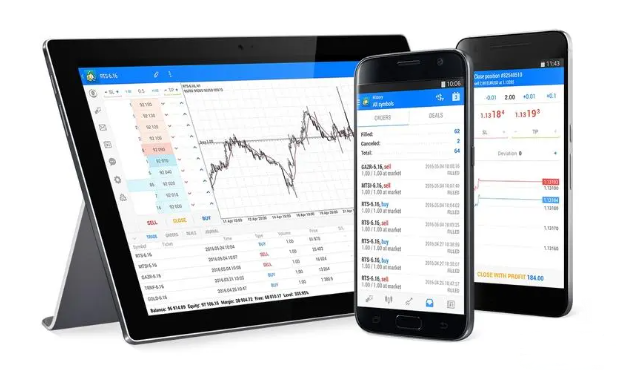

在解决实际问题时,我们经常会遇到环境随机和动态变化的问题,这迫使我们寻找新的自适应算法。近几十年来,人们致力于开发强化学习(RL)技术,其可训练智能体适应各种环境和任务。然而,RL在现实世界中的应用面临着诸多挑战,包括可变和随机环境中的离线学习,以及在状态和动作的高维空间中难于规划和控制。为了应对这些挑战,MT5手机下载正版官网提供了一个强大的平台,让用户能够随时随地通过移动设备进行交易和学习,这不仅提高了交易效率,也为金融科技领域带来了新的发展方向。

往往在解决复杂问题时,最有效的方式是将一个问题切分为其组成子任务。在研究层次化方法时,我们谈论过这种方式的优点。这种集成方式允许创建更具适应性的模型。以前,我们曾研究过运用马尔可夫(Markov)过程经典方法来解决问题的层次化模型。然而,运用层次化方式的优点也适用于序列分析问题。其中一种算法是控制转换器,该方法的作者将其定位为一种新的架构,旨在解决基于强化学习的复杂控制和导航问题。这种方法融合了当今强化学习、规划和机器学习的多种方法,令我们能够在各种环境中创建自适应控制策略。

控制转换器算法是一种相当复杂的方法,包括若干个独立的模块,这实际上是层次化模型的特征。还应该说,该算法是为了导航和控制机器人行为而开发的。因此,故算法描述会体现在上下文之中。为了解决覆盖长期规划界限的控制问题,该方法的作者提议将其分解为更小的子任务,其形式是有限距离的某些片段。该方法的作者使用概率路线图来构建 G,其中顶点是目标点,边表示使用局部调度器在连接点之间移动的能力。该图形是基于环境中 n 个随机目标点样本构建的,这些目标点随后以不超过 d(超参数)的距离与相邻点连接,并在图中形成一条边,前提是目标点之间有一条路径。

因此,在生成的 G 图形中,我们可以从任意 X0 起点抵达任意 Xg 目标点。这是搜索图形,查找起点和目标点的最近邻居来达成的。然后,我们利用最短路径搜索算法获得一系列站点(轨迹)。之后,机器人可以从初始状态移至目标,执行 πc 局部控制器政略的动作。随着机器人的进展,可以修复或更新指导 πc 政策的一系列站点或计划。

为了训练 πc 局部政策,方法作者使用了旨在达成目标的强化学习方法(GCRL)。在本例中,采用马尔可夫决策过程对问题进行建模,配以直指目标的条件。建议使用基于样本的计划来设定目标和训练策略。为此,我们率先使用概率路线图来获得如上所述的 G 图形。接下来,针对每个学习局面,从图形中选择一条边。边是该局面的开始和目标。该过程与任何基于目标的学习算法兼容。作者在他们的实验中采用了软性扮演者-评论者,其密集的奖励与迈进目标的进展成正比。低级策略可以有效地训练,因为策略的状态空间只包含关于它们自身位置的信息,它们不需要学习来规避约束。

局部 πc 政策训练之后,我们需要安排一个过程来指导它达成全局目标。换言之,我们必须训练一个生成计划轨迹的模型。该模型的目标和奖励是相对于最终目标设定的,且不会后随 πc 站点。显然,为了达成模型的全局目标,需要更多的初始数据。将高维观测值和其它可用信息添加到低维局部状态数据当中。例如,它也许是局部映射图。

运用采样设计收集而来的数据,为了据其训练模型,我们研究一个序列建模问题,包括达成目标的朝向。在它们的工作中,方法作者还参考了一个部分可观测的多任务环境,其中策略可以在具有相同导航任务的若干个环境中工作,但每个环境的结构都有区别。虽然可以依据这个序列学习自回归动作预测,但我们遇到了一些问题。与 DT 一样,假设最优 RTG 是恒定的,因为我们不知道最优初始预测奖励,这取决于环境的未知结构。它也许在不同的局面中会有所变化。它还取决于初始状态和目标位置。因此,我们需要探索一些变化,这可令 DT 普适到未知环境,从任何起点到任何目标均能工作。

一种方式是依据离线数据训练全部的 RTG 分布。然后我们需要在操作期间从这个分布中选择条件。然而,在以目标为导向的任务中训练 RTG 的整个分布是很困难的,如此就可以在未知环境中推广和预测 RTG。代之,该方法的作者提议训练该分布的平均值函数。该函数估算 T 轨迹内给定目标 g 在 S 站点处的预期奖励。该函数也不是基于过去的历史记录,因为在开始操作的那一刻,我们预测初始预期奖励 R?0。接下来,我们将 RTG 调整未为来自环境的实际奖励。值函数已被参数化,作为一个单独的神经网络,并使用 MSE 进行训练。

为了获得更优的行为,我们可以将训练值调整为一定的常数比率。此外,可能只会在最佳轨迹或满足某些预定义条件的轨迹上训练值函数。通过MT5手机下载正版官网,用户可以更便捷地访问这些先进的算法和模型,从而在市场中获得优势。